A mesterséges intelligencia körébe tartozó technológiai fejlesztések mindannyiunk életében jelen vannak, ennek minden pozitív és negatív hozadékával együtt. Nem csak informatikusokat megmozgató kérdésekről tartott előadást Bárd Imre 2019. május 16-án az Eötvös Collegium Informatikai műhelye kurzusának keretén belül. A mesterséges intelligencia, illetve az ezzel kapcsolatos technológiák kérdésköre társadalomtudományi szempontból vizsgálható etikai dilemmákat is felvet. Hogyan lehet(ne) a mesterséges intelligencián alapuló fejlesztéseket összhangba hozni alapvető morális értékekkel? Tudósításunkból kiderül, milyen szempontok vetődnek fel a téma kapcsán, és milyen lehetséges megoldások képzelhetők el.

Bárd Imre, a London School of Economics doktorandusza és a Nesta innovációs alapítvány kutatója tartott előadást a mesterséges intelligenciáról az Eötvös Collegium Informatikai műhelyében. Problémafelvető előadásában társadalomtudományos szempontokat érvényesített, így gondolatmenetét ajánljuk a nem informatikus olvasóinknak is. Napjainkban számos ország mesterséges intelligenciával kapcsolatos stratégiájának megalkotása zajlik, és egyre több életterületen jelennek meg az ilyen jellegű technológiák. Ugyanakkor az ellenvélemények is egyre erőteljesebben kulminálódnak a mesterséges intelligenciával szemben: nem káros-e összességében egy olyan jelenség, amely (diagnosztikai MI-eszközök esetében) akár téves rákdiagnózishoz is vezethet? Ha egyértelmű válasz nem is adható, bizonyos problémacsomagok és megoldási lehetőségek már kirajzolódnak.

A mesterséges intelligencia (MI; angolul: Articificial Intelligence – AI) fogalmának nincs univerzálisan elfogadott definíciója. Történetében komolyabb lépcsőfoknak tekinthető a Darmouth-i Egyetem 1956-ban tartott tízhetes workshopja, amelyet széles körben a mesterséges intelligencia mint tudományterület létrejöttének tartanak. Általános jellemzőként említhető, hogy a mesterséges intelligencia olyan technológiákat takar, amelyek képesek emberi módon, illetve racionálisan cselekedni és viselkedni (thinking and acting humanly, thinking and acting rationally) – persze, mint ahogyan arra Bárd Imre is felhívta a figyelmet, ezek nagyon általános jellemzők, és a MI mibenlétének pontosabb megértéséhez specifikálni kellene őket. Andrew Y. Ng informatikus szerint az MI minden iparágat át fog alakítani (amennyiben ez még nem történt meg), csakúgy, mint az elektromosság megjelenése.

Bárd Imre a 2019. évi Smart konferencián (forrás: ivsz.hu)

A mesterséges intelligenciát többféleképpen csoportosíthatjuk. A leíró MI alapvetően deduktív módon működik, a szimbolikus gondolkodáson alapul, kézzel kódolt logikai relációk felismerésére alkalmas. Létezik olyan fajtája is a mesterséges intelligenciának, amely a statisztikai alapú tanulás elve mentén működik, és absztrahálni is képes bevitt adatok alapján. A harmadik típus pedig a különböző kontextusok közötti átjárhatóságot is tudja biztosítani, ilyenképpen nemcsak egy adott kontextuson belüli specifikus kimenetre alkalmas, hanem generalizáltan többféle feladat végrehajtására is. Egy másik kategorizáció szerint beszélhetünk szűken vett mesterséges intelligenciáról (ez egyféle feladat végrehajtására alkalmas, ami azonban összetett feladat is lehet, lásd önvezető autók), generalizált mesterséges intelligenciáról (többféle feladat végrehajtására képes) és super MI-ről (a legmagasabb emberi képességeket igénylő feladatoknál is magasabb rendű feladatok végrehajtására is alkalmas).

Az egyre több életterületen jelen lévő mesterséges intelligencia sok problémát generál. Bárd Imre felvetette, hogy az sem kizárt: jobban ismernek minket ezek a technológiák, mint mi magunkat. Gondoljunk csak arra, mennyi adatot szolgáltatunk a puszta létezésünkkel! Ez alatt egyáltalán nem csak a keresési előzményeinkre kell gondolni: a fő etikai kérdést az veti fel, hogy vajon milyen következményei lehetnek annak, ha a technológiák akár már érzelmi vetületekre is tudnak következtetni bizonyos adatokból. Szintén problematikus, hogy kapitalizálódik a kognitív lekötöttségünk, ami a döntési szabadságunk megkérdőjeleződését is maga után vonja. Csak egy videót megnézek a Youtube-on – ki ne mondta volna már ezt, hogy aztán órákkal később az eredeti tervhez képest teljesen más jellegű tartalmakat nézegetve eszméljen fel újra. Kinek az érdeke mentén strukturált az a rendszer, amely egyre szélsőségesebb tartalmak felé terelgeti felhasználóját? A mi döntésünk-e vajon, hogy az elénk táruló videókra rákattintunk, vagy pedig az ember kognitív korlátainak kihasználása történik? Válasz helyett álljon itt Bárd Imre egy másik problémafelvetése: az talán veszélyesebb, ha az MI az ember kognitív korlátait használja ki, mint hogyha meghaladná a legjobb emberi képességek szintjét.

A mesterséges intelligenciára épülő technológiák emberközpontúvá tételéhez Bárd Imre szerint szükség lenne egy elvárásrendszerre, amely az igazságosság, az átláthatóság és a felelősségre vonhatóság kritériumait foglalja magában.

Az igazságosság elvárása azt implikája, hogy az MI-technológiák jelenlegi fejlettségi szintje igazságtalanságokat is tud szülni; ennek egyszerű oka, hogy rossz bevitt adatok esetén a következtetés, az output is hibás lesz. Ez a folyamat hatással lehet az emberek életének olyan területeire is, mint a pénzügyek, munkavállalás vagy egészségügy: egy nem megfelelő adat bevitele egy MI-n alapuló rendszerbe negatívan és igazságtalanul befolyásolhatja pl. a hitelfelvételt, cégek HR-stratégiáját vagy akár az orvosi diagnózisokat is. A megoldás az lehet, ha reprezentatív adatok bevitele történik. Szintén az igazságossággal összefüggő probléma, hogy a bevitt adatok sokszor akarva-akaratlanul társadalmi előítéleteket testesítenek meg, és ebből kifolyólag örökítenek is tovább, mindezt ráadásul egy látszólag objektív, algoritmikus rendszer kereteibe ágyazva. Mind a reprezentativitással, mind az előítéletekkel összefüggésben releváns lehet az arcfelismerő programok problémája: mivel ezek a rendszerek nagyrészt középkorú, fehér férfiak arcának felismerését tanulják meg, sok esetben nem tudják felismerni az ezeknek a kritériumoknak nem megfelelő arcokat. A bevitt adatok reprezentativitásának hiánya így termel hibás kimenetet, és táplál tovább egy társadalmi előítéletet.

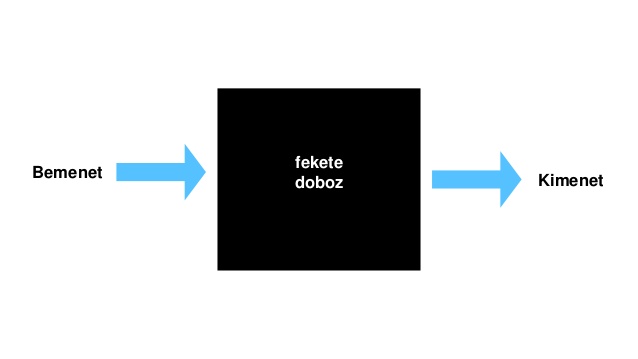

A következő kritérium, amelynek az emberközpontú MI meg kellene, hogy feleljen, az átláthatóság elvárása. Ez egyrészt a konkrét informatikai folyamat megérthetőségét jelenti: a bemenet és a kimenet között van egy ún. fekete doboz, amelynek a működése Bárd Imre szerint – habár már jobban értik a tudósok, mint néhány éve – még mindig nem kellőképpen feltérképezett (ezt az előadás után informatikusok is megerősítették a közönség soraiból). A megérthetőséghez kapcsolódik a felhasználók és fejlesztők igényei közti (látszólagos) ellentmondás is: a felhasználók szeretnék érteni a rendszerek működését, a fejlesztők pedig szeretnék védeni a szellemi tulajdonukat – mindkettő védhető álláspont, nincs azonban még megoldás a dichotómia feloldására.

Az ismeretlen és félelmetes fekete doboz (forrás: slideshare.net)

Végezetül elérkeztünk a harmadik szemponthoz, amelynek érvényesülni kellene az emberközpontú mesterséges intelligencia kérdésében: ez az elszámoltathatóság, felelősségre vonhatóság kritériuma. Jelenleg azonban ennek kapcsán is csak a problémafelvetés adott: kit lehet felelősségre vonni az esetleges károkért?

Az emberközpontúság kritériumainak kifejtése után az előadó ismertetett a mesterséges intelligenciával kapcsolatos egyéb problémákat. Az egyik legsúlyosabb kérdés, hogy bizonyos privát szuperhatalmak kezében milyen jellegű és mennyiségű hatalom összpontosul tőke, infrastruktúra, adat és tudás tekintetében. A tőkekoncentráció problémáját talán elég annyival illusztrálni, hogy hogyan viszonyulnak egymáshoz mennyiségileg néhány privát szuperhatalom 2017-es bevételei és egyes államok az évi GDP-je: a Netflix bevételei meghaladták Málta GDP-jét, az Apple jövedelmei pedig Portugália bruttó hazai termékét… Szintén fontos probléma a jövőben az autonóm fegyverek lehetősége, illetve a munkaerőpiac átalakulása (ez nem egyszer a tömeges munkanélküliség vízióját jelenti).

Mindezekre a megoldás a mesterséges intelligencián alapuló technológiák emberközpontúvá alakítása lehet. Ennek valós emberi igények mentén, a technológiai lehetőségek figyelembe vételével kell történnie. Az emberközpontúság normaként fogalmazódik meg az MI területén, ami azt is jelenti közvetve, hogy eddig más szempontok domináltak a kérdésben. A felelősség a civil, az akadémiai, az üzleti és a politikai szférát egyaránt terheli. Az irányelveket az Emberi Jogok Egyetemes Nyilatkozata és az ENSZ fenntartható fejlődéssel kapcsolatos célrendszere jelenthetik. Nehézségként merül fel, hogy globális kooperáció lenne szükséges az emberközpontú dizájn kialakításához, és hogy az etikai diskurzus valójában elvonja a figyelmet a kötelező szabályozásról (ez az ún. ethics washing jelensége). Arról az általános filozófiai kérdésfelvetésről nem is beszélve, hogy az emberi lét mibenlétét nehéz meghatározni és egyértelmű kritériumokhoz kötni, így a mesterséges intelligencia emberközpontúsága is alapvető terminológiai akadályokba ütközik.

Bárd Imre előadása után a közönség soraiban is élénk diskurzus alakult ki a témáról. Felmerült például az a kérdés, hogy elvont fogalmakat (pl. titok) hogyan lehetne „elmagyarázni” egy MI-technológiának. Szintén az előadást követő beszélgetés során hangzott el az a felvetés, hogy sokszor a védett adatok figyelembe vétele lenne hasznosabb a kimenet helyességének szempontjából. Megfogalmazódott az a probléma is, hogy az emberek nem érzik még zsigerileg magukénak a mesterséges intelligenciával kapcsolatos társadalmi kérdéseket, amelyhez kapcsolódik, hogy az ELTE informatikusképzésének kínálatából is hiányoznak az etikai kérdésekre reflektáló kurzusok.

Hogy azonban a napfényes oldalát is lássuk a mesterséges intelligenciának, zárjuk a témát egy gondolatkísérlettel. Bár etikai szempontból elborzasztó azon morfondírozni, hogy mi legyen betáplálva egy önvezető autóba: egy nagymamát vagy egy kismamát üssön el adott esetben, ha nem lehet elkerülni a balesetet, azonban összességében a technológia révén még mindig lehet, hogy kevesebb baleset lesz, mint jelenleg.

A kiemelt kép forrása az előadás Facebook-eseménye.